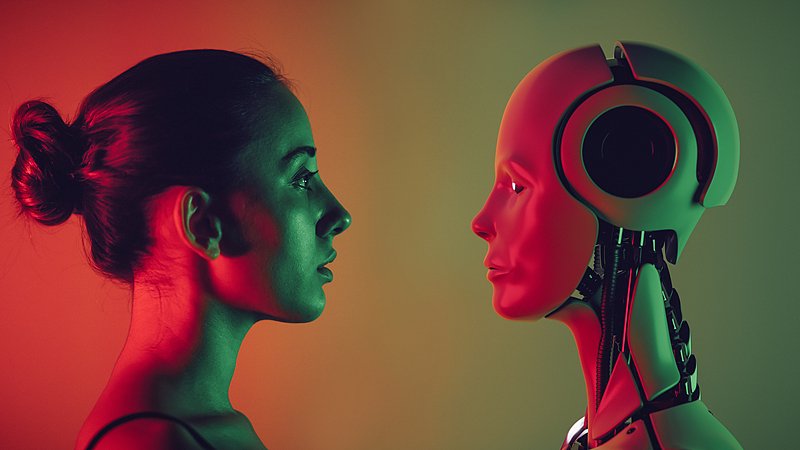

摘要:Apple Siri失败了,但越来越多的“ AI Siri”获得了融资。在过去的六个月中,曲目“ AI声音”一直是密集的融资。特别值得注意的是,这些融资大多数都是庞大的,并且投资于早期团队。例如,很快,AI语音应用程序WISPR流量通过“无声意见”完成了3,000万美元的融资,并结合了5600万美元的融资; Cartesia语音模型公司在3月完成了6400万美元的A系列融资,结合了9100万美元; AI语音合成公司在一月份宣布,它完成了1.8亿美元的C融资,并赞赏超过30亿美元。同时,无论是Meta,OpenAI,Google等巨型技术,还是Minimax等初创公司,它们都非常强烈地发布了他们自己的语音模型还是语音产品。 Siri还透露了诸如Chatgpt或Claude之类的模型以维护开发语音接触。这些新闻毫无例外地指出了AI声音的普及。为什么在过去的六个月中,AI语音场爆炸? Shengzhi副总裁Huang Yunhe认为,语音对话很快从应用程序在AI期间存在的入口级别的功能模块中迅速出现,并与大型模型的支持有着巨大的关系。在智能扬声器非常受欢迎的时候,我们熟悉的大多数智能扬声器品牌都配备了声音和Zhi的远场声学互动技术,例如xiao AI,tmall genie,xiaodu扬声器等。一词“ Little Love”一词确实来自很好。该公司成立于2016年,探索了声学 + AI的横截面。但是,作为一家在幕后提供AI声学技术的公司,在大型模型接近之后,它决定无疑将自己投入到开发自己的C-End产品上。毫无疑问,他们在T中看到了新的商机他的“大型模型 +语音”浪潮及其AI耳机目前已发送到近100万套。此前,Shengzhi Huang Yunhe的Geek Park兼副总裁谈到了AI语音市场爆炸的逻辑,语音接触的“块”点以及它将如何影响我们的未来。以下内容是根据Huang Yunhe在Heshengzhi的角色中组合的:AI发音的想象力比Siri |图片来源:Internet AI,为什么声音为什么今天爆炸?在过去的两年中,更多,Moremore和更多人AI的声音启动团队获得了大量的融资,并以集中的方式爆炸。重要的驱动因素之一是,大型模型可以首次“编程”声音的基本能力。 “可编程”一词是指通过清晰的接口和逻辑可以称呼,合并,修改和控制的功能或某些东西。以前,本文本可以编程,图像可以被编程,即使视频也进行了编程(例如视频编辑软件)。但是声音不仅仅是“输入”或“输出”介质,而且内部复杂的结构和信息是困难的直接“程序”和“理解”软件。传统的语音识别更多是关于将声音转换为文本,然后处理文本。深圳和成都的许多团队曾经制作语音标签。获得声音后,他们可以将它们转换为文本并将其放在不同的标签上,例如不同属性和意图的标签。大型模型到达后,可以将标记的任务赋予大型模型,该模型比大量的Manu -Manu团队更快,准确。过去的NLP后面,有一组勤奋的操作将它们标记在那里,从而使AI系统能够识别每个句子的目的。以前,每当将功能添加到声音的发展中时,就需要写作E从一开始,这是及时而勤奋的劳动。例如,如果您希望明智的扬声器支持“订单要点”,则需要构建一组单独的移动语音和语义逻辑,这是昂贵且漫长的周期。现在可以解决AI大型模型。更重要的是,通过大型模型依靠对多模式数据的深入了解,以及对声学信号的详细分析,除了文本信息之外,听起来本身的信息越多,就开始直接捕获,理解和通过AI系统“编程”。此可编程性意味着AI可以处理听起来像数据。它可以研究频率,振幅和声波,剥夺情感特性,确定不同的声音来源,声音资源,甚至猜测您的目标。目前,声音不再只包含“您所说的话”,而是“您说的”,“在哪里说”,谁说“”和“在说什么之后对您的期望”。作为一个Sult,声音成为了真正的参与引擎。真正的声音互动不是“声音”,而是“声音”。实际上,许多人认为语音互动是“声音”。但是实际上,语音一词是一个狭窄的概念。 “声音”包含更多丰富的元素:音调,音调,节奏,情绪和更重要的声音。叹息,笑声,蛋,蛋糕等)。例如,当您咳嗽时,与AI交谈时,它可以识别咳嗽,然后告诉您更多的水。例如,当您在咖啡馆里说:“帮助我找到一个安静的地方。” AI不仅需要了解您的说明,而且还要从背景声音中判断您当前的环境,以推荐附近的图书馆。当我说“下一代对话和接触的入口不是“声音”,而是“声音”时,我的意思是,AI系统不再仅仅依靠您所说的话”,而是能够充分看到和理解环境“声学场景”中的所有关键元素。只有当Ai c“声音”中包含的充分理解和解析的多维信息,即使大公司易于赚钱,也不会使用语音接触的深度需求。 "" Listening clearly "is subject to physical forces. Thick, and sound can indicate excessive penetration A acoustic level is really necessary, such as suppressing environmental noise, suppression of noise flooring, suppressing moaning, suppressing falling, etc. Maintaining a “UI interface”, what will look like interThis face? Elements can include: emotional recognition: AI determines the user's emotional state by examining the tone, volume, and speed of speech. For example, your voice is颤抖,AI可能认为您是紧张的或悲伤的。是的,您了解您说的话,但也了解您想做什么。例如,如果您说“播放音乐”,AI决定根据自己的情绪弹奏石头或古典作品。语音纹理识别:可以通过唯一的Wave Sound属性来识别不同的用户。例如,在家中的明智扬声器可以自动切换到“儿童模式”模式,这为孩子的声音提供了安全的响应。情绪情绪:AI反应需要情感表达。例如,说“别担心,我会帮助您解决它”,而不是机械“好的,处理”。这些要素的背后是从“功能取向”到“情感取向”的转变,这将伤害人们。这种类型的接触可以显着提高长期接触的质量和亲密关系。不仅如此,从狭窄的“声音”感到广泛的“声音”感,当AI不仅可以收到用户说明,而且可以从整个物理世界中获得实时反馈,我们可以速度“声学世界模型”。 “声学世界模型”可以理解声音发电,传播和与物理世界互动的基本定律。它不仅必须“清楚地听”和“理解”,而且还具有“声学常识”和“声学推理”的能力:它可以证明这本书是在地面上降临还是从声音中倒下的盒子;它可以通过Echo来判断房间的大小和开放性;它将更好地理解“从远到附近的脚步”背后的运动逻辑。将来,当这种声学世界模型与视觉和语言模型深入融合时,具体的智能机器人将不再是“聋哑”和冷的。这就是我们要做的。

摘要:Apple Siri失败了,但越来越多的“ AI Siri”获得了融资。在过去的六个月中,曲目“ AI声音”一直是密集的融资。特别值得注意的是,这些融资大多数都是庞大的,并且投资于早期团队。例如,很快,AI语音应用程序WISPR流量通过“无声意见”完成了3,000万美元的融资,并结合了5600万美元的融资; Cartesia语音模型公司在3月完成了6400万美元的A系列融资,结合了9100万美元; AI语音合成公司在一月份宣布,它完成了1.8亿美元的C融资,并赞赏超过30亿美元。同时,无论是Meta,OpenAI,Google等巨型技术,还是Minimax等初创公司,它们都非常强烈地发布了他们自己的语音模型还是语音产品。 Siri还透露了诸如Chatgpt或Claude之类的模型以维护开发语音接触。这些新闻毫无例外地指出了AI声音的普及。为什么在过去的六个月中,AI语音场爆炸? Shengzhi副总裁Huang Yunhe认为,语音对话很快从应用程序在AI期间存在的入口级别的功能模块中迅速出现,并与大型模型的支持有着巨大的关系。在智能扬声器非常受欢迎的时候,我们熟悉的大多数智能扬声器品牌都配备了声音和Zhi的远场声学互动技术,例如xiao AI,tmall genie,xiaodu扬声器等。一词“ Little Love”一词确实来自很好。该公司成立于2016年,探索了声学 + AI的横截面。但是,作为一家在幕后提供AI声学技术的公司,在大型模型接近之后,它决定无疑将自己投入到开发自己的C-End产品上。毫无疑问,他们在T中看到了新的商机他的“大型模型 +语音”浪潮及其AI耳机目前已发送到近100万套。此前,Shengzhi Huang Yunhe的Geek Park兼副总裁谈到了AI语音市场爆炸的逻辑,语音接触的“块”点以及它将如何影响我们的未来。以下内容是根据Huang Yunhe在Heshengzhi的角色中组合的:AI发音的想象力比Siri |图片来源:Internet AI,为什么声音为什么今天爆炸?在过去的两年中,更多,Moremore和更多人AI的声音启动团队获得了大量的融资,并以集中的方式爆炸。重要的驱动因素之一是,大型模型可以首次“编程”声音的基本能力。 “可编程”一词是指通过清晰的接口和逻辑可以称呼,合并,修改和控制的功能或某些东西。以前,本文本可以编程,图像可以被编程,即使视频也进行了编程(例如视频编辑软件)。但是声音不仅仅是“输入”或“输出”介质,而且内部复杂的结构和信息是困难的直接“程序”和“理解”软件。传统的语音识别更多是关于将声音转换为文本,然后处理文本。深圳和成都的许多团队曾经制作语音标签。获得声音后,他们可以将它们转换为文本并将其放在不同的标签上,例如不同属性和意图的标签。大型模型到达后,可以将标记的任务赋予大型模型,该模型比大量的Manu -Manu团队更快,准确。过去的NLP后面,有一组勤奋的操作将它们标记在那里,从而使AI系统能够识别每个句子的目的。以前,每当将功能添加到声音的发展中时,就需要写作E从一开始,这是及时而勤奋的劳动。例如,如果您希望明智的扬声器支持“订单要点”,则需要构建一组单独的移动语音和语义逻辑,这是昂贵且漫长的周期。现在可以解决AI大型模型。更重要的是,通过大型模型依靠对多模式数据的深入了解,以及对声学信号的详细分析,除了文本信息之外,听起来本身的信息越多,就开始直接捕获,理解和通过AI系统“编程”。此可编程性意味着AI可以处理听起来像数据。它可以研究频率,振幅和声波,剥夺情感特性,确定不同的声音来源,声音资源,甚至猜测您的目标。目前,声音不再只包含“您所说的话”,而是“您说的”,“在哪里说”,谁说“”和“在说什么之后对您的期望”。作为一个Sult,声音成为了真正的参与引擎。真正的声音互动不是“声音”,而是“声音”。实际上,许多人认为语音互动是“声音”。但是实际上,语音一词是一个狭窄的概念。 “声音”包含更多丰富的元素:音调,音调,节奏,情绪和更重要的声音。叹息,笑声,蛋,蛋糕等)。例如,当您咳嗽时,与AI交谈时,它可以识别咳嗽,然后告诉您更多的水。例如,当您在咖啡馆里说:“帮助我找到一个安静的地方。” AI不仅需要了解您的说明,而且还要从背景声音中判断您当前的环境,以推荐附近的图书馆。当我说“下一代对话和接触的入口不是“声音”,而是“声音”时,我的意思是,AI系统不再仅仅依靠您所说的话”,而是能够充分看到和理解环境“声学场景”中的所有关键元素。只有当Ai c“声音”中包含的充分理解和解析的多维信息,即使大公司易于赚钱,也不会使用语音接触的深度需求。 "" Listening clearly "is subject to physical forces. Thick, and sound can indicate excessive penetration A acoustic level is really necessary, such as suppressing environmental noise, suppression of noise flooring, suppressing moaning, suppressing falling, etc. Maintaining a “UI interface”, what will look like interThis face? Elements can include: emotional recognition: AI determines the user's emotional state by examining the tone, volume, and speed of speech. For example, your voice is颤抖,AI可能认为您是紧张的或悲伤的。是的,您了解您说的话,但也了解您想做什么。例如,如果您说“播放音乐”,AI决定根据自己的情绪弹奏石头或古典作品。语音纹理识别:可以通过唯一的Wave Sound属性来识别不同的用户。例如,在家中的明智扬声器可以自动切换到“儿童模式”模式,这为孩子的声音提供了安全的响应。情绪情绪:AI反应需要情感表达。例如,说“别担心,我会帮助您解决它”,而不是机械“好的,处理”。这些要素的背后是从“功能取向”到“情感取向”的转变,这将伤害人们。这种类型的接触可以显着提高长期接触的质量和亲密关系。不仅如此,从狭窄的“声音”感到广泛的“声音”感,当AI不仅可以收到用户说明,而且可以从整个物理世界中获得实时反馈,我们可以速度“声学世界模型”。 “声学世界模型”可以理解声音发电,传播和与物理世界互动的基本定律。它不仅必须“清楚地听”和“理解”,而且还具有“声学常识”和“声学推理”的能力:它可以证明这本书是在地面上降临还是从声音中倒下的盒子;它可以通过Echo来判断房间的大小和开放性;它将更好地理解“从远到附近的脚步”背后的运动逻辑。将来,当这种声学世界模型与视觉和语言模型深入融合时,具体的智能机器人将不再是“聋哑”和冷的。这就是我们要做的。